普段は開発系Tipの記事が多いですが、今回は趣向を変えてAppleのVisionProが発表されたためHoloLensアプリ開発者としての思うところをまとめていきます。

〇Apple VisionProとは?

Apple Vision Proは先日開催されたAppleの開発者向けカンファレンスWWDC(World Wide Developer Conference)で発表されたApple社初のウェアラブルXRデバイスです。

発表では発売自体は24年でありますが、開発者向けに日本を含めた各地で体験の機会があるようです。

Vision OSと呼ばれるOSが新たに開発されており、これはiOSを元として開発されているようで、Windows10をベースにWindows Holographicを搭載しているMicrosoft HoloLensに似ている作りと言えると思います。

そのためHoloLensがUWP製アプリケーションを実行可能なようにiPhoneなどに向けて開発されていたアプリケーションがVision Proで実行できるとの情報もあります。

〇発表

1時間20分からVisionProが発表されました。

〇xRとSpatial Computing

Appleの発表を見るにはVisionProをSpatial Computerと呼んでおり私が見る限り一度もxR(VR、AR、MR)というワードは出ませんでした。

おそらくMicrosoftがあえてMixedRealty(複合現実感)という言葉にこだわったように既存のイメージとの差別化や技術の革新によってその差があいまいになっていっているのであえてレイヤーが大きい概念を使用したと思っています。

Spatial Computing(空間コンピューティング)は、現実空間にデジタル情報をオーバーレイし、拡張現実体験を可能にする技術です。従来の画面上の情報表示ではなく、私たちが実際に存在する壁、床、そして場合によっては机などの物理的な要素にデジタル情報を統合することが特徴です。

Spatial Computingは、現実空間における物理的な要素とデジタル情報を統合する技術やアプローチを全体指します。

これには、センサー、カメラ、コンピュータビジョン、3Dマッピングなどの技術が使用され、現実空間をデジタル空間と結びつけることが可能です。

VRやAR、MRといったxR(ExtendedReality=拡張現実感)技術と非常によく似た概念でありますが、こちらは現実世界と仮想的な要素を組み合わせる技術や体験を包括する概念です。

つまり、Spatial Computingは、XRの一部として現実空間のデジタル情報への統合を実現するための技術やアプローチを指しています。XRは、Spatial Computingを含むさまざまな拡張現実技術を包括的に表す概念です。

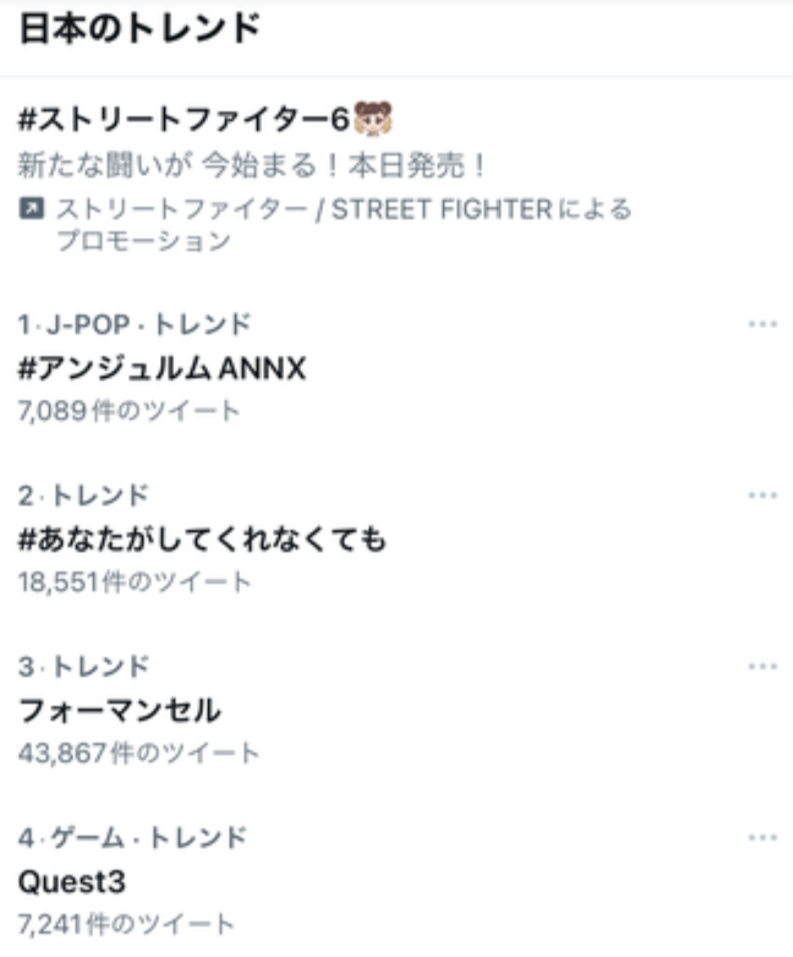

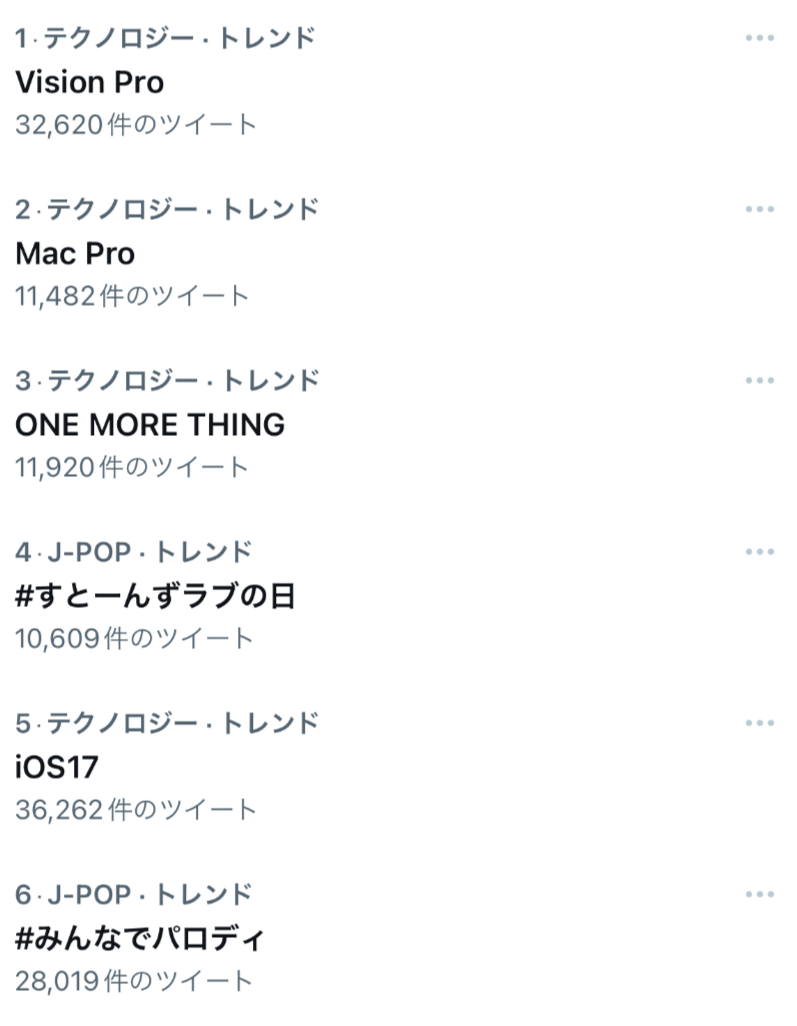

〇トレンドのカテゴリー

Vision Proが発表される前週にMeta社により新型のデバイスMeta Quest 3が発表されました。

この際にもVisionPro同様にSNSのトレンドに乗る反応を見せましたが、この際のカテゴリーはゲームでした。またSNSのアイコンもアバターが多くVRChat愛好者を含めた既存のユーザー、開発者が多く反応していたように見られました。

しかしVisionProが発表された際のトレンドカテゴリーはテクノロジーであり、また開発者向けのイベントでありながらNHK、Yahooをはじめとしたテレビ、ネットメディアのトップニュースだけでなく山手線などの車内ニュースでも大きく取り上げられていました。

Appleが初めて発表した新タイプのデバイスということもあり、iPhoneの再来という期待をもって大きく取り上げられました。

この差もAppleというブランドだからこそなせる業なのではないでしょうか?

〇Vision Proの機能と既存の技術の比較

Vision Proは現在まだ展開されておらず、筆者自身も体験していないためPV及びすでに体験した人の記事を見ての既存の技術との比較になります。

①EyeTracing&HandTracking

EyeTracingは装着者の目を認識してみているものを認識する機能です。

HandTrackingは装着者の手を認識してジェスチャの検知やデジタル情報との対話(つかんだり押したり)を実現します。

どちらもMicrosoft HoloLens、Varjo XR-3、Meta Quest、VIVE(上位機種)、MagicLeap 2等ですでに実装されている技術です。

HandTrackingは近年この手のデバイスでは標準で搭載されている機能に思えます。

HandTrackingに関してはその基礎技術がセンサーであるUltraLeap(旧称LeapMotion)をベースにしていることが多く実際にVarjoXR-3にはUltraLeapが搭載されています。 HandTrackingの精度はこのセンサーを比較対象にしてどのくらい高いかが気になるところです。

HoloLens 2、Varjo XR-3がこの中では一番Vision Proと技術的比較として似ているように感じますが、EyeTracingはユーザーごとに目をキャリブレーションする必要があり、メガネの有り無し、裸眼、コンタクトなどによって認識が変わります。

HoloLens 2ではEyeTracingを応用した虹彩認証によってパスワードを入力せずにログインすることができますが、日用使いする中で虹彩認証が反応してログイン出来たらラッキーくらいの感覚となっており、既存のデバイスではその場限りではストレスなく最高の体験をできますが、Appleがどのように改善しているのか? もしくは既存のデバイスと同等程度なのかが気になります。

②ビデオシースルー

Microsoft HoloLens、Magic Leap2との大きな違いがこちらになると思います。

HoloLensやMagic Leap2はディスプレイ(ゴーグル部分)が透明パーツとなっており、HUDに近いイメージでデジタル情報が表示されます。このアプローチは光学シースルーと呼ばれています。

そのためデバイスの電源が入っていないときにも周囲を見ることができます。(ただの眼鏡になります。)

Vision Proの場合ゴーグルの周囲に搭載されているカメラが周囲の物理環境を撮影して、その映像がゴーグルに表示される仕組みになっています。このアプローチは一般的にビデオシースルーと呼ばれています。

これはMetaQuest 2及びMeta Quest Proに採用されているMRモードと同種のアプローチになりますが、このアプローチの場合原理的には複数のカメラを組み合わせることで見ている映像にゆがみが発生してしまいます。

これがビデオシースルーを採用しているデバイスの最大の弱点で、空間がゆがんで見えることはユーザー体験に影響することもあります。

また露光の問題もあり、例えば太陽光が差し込む窓辺の室内で使用した場合、明るさの差によって露光調整が間に合わずまぶしく見えるor暗く見えるという欠点もあります。

実際に体験された方の感想を見るに空間のゆがみは無いようです。ゆがみとは別に補正により手元の奥行きが実際と異なってみる(実際に手がある一と視覚上見えている自分の手がずれて見える)という問題もまた別の弱点としてあるため実際に筆者自身が見てみるまでは気になり続けるところだと思いますが、少なくともMetaQuestよりはよいようです。

まずVision Proを覗いたときの空間の歪みですが、本当になかったです。

— ARおじさん / MESON CEO (@AR_Ojisan) 2023年6月7日

QuestProなどを体験すると見られる自分の手のサイズが大きく感じることもないし、実際の物体の距離感も自然に感じました。

視界の端の歪みも何度も確認しましたが、ありませんでした。。。https://t.co/M40y6NgCCZ

③(逆シースルー)

筆者としてはこの機能が一番驚きましたが、Meta Questなどのビデオシースルーデバイスでは着用者の顔はゴーグルで覆われているため周囲にいる人からどこを見ているのか?どのような表情なのかは変わりずらいです。Vision Proではゴーグル外側に着用者の顔が表示されることで周囲の人からもどこを見ているのかがわかりやすく、ゴーグル着用者もビデオシースルーによって周囲の人を見ることができるのでより自然なコミュニケーションを行うことができると言われています。

これは既存の技術はなく独自だと思います。

正直筆者個人の感想としてはこの機能をオミットしてその分値段を下げてほしいと思うところですが・・・実際に使用してみないとその価値はわからないのかなと思っています。

④SpatialAwareness(空間認識)

空間認識はSpatial Computingを実現する上で必要な要素の一つで、Microsoft HoloLensの機能が既存のデバイスとしては比較しやすいです。

HoloLensではSpatial Mesh(空間メッシュ)と呼ばれる認識した物理情報に重ねるようにメッシュを張ることができ、これによって物理空間とデジタル情報の対話を実現しています。

Vision Proでは影を落とすことでオブジェクトの距離感を認識しやすくしたりといった独自の機能があります。

光学シースルーデバイスでは黒=何も描画しない=透明となり、影を含めた黒系の描画が苦手としています。 この機能はビデオシースルーデバイスならではの機能です。

〇開発者向けの情報

Unityではすでにβ版の開発プログラムの募集が開始しています。

We’re so excited about our collaboration with @Apple, and how devs can use our RT3D tools to bring new and existing apps and games to Apple Vision Pro and create incredible spatial experiences for users.

— Unity (@unity) 2023年6月5日

Learn more: https://t.co/QDYdEljavv pic.twitter.com/FX7Ybh7coN

またApple公式でも開発者向けのプログラムの募集が発表されています。(7月から開始)

〇筆者の所感

ここまでにもところどころ所感を混ぜていきましたが、世界的にもインパクトがある発表で筆者自身も期待をしています。

筆者がHoloLensと出会った5年前より前からずっとAppleのデバイスという話題や噂はありましたがついに現実となっています。

ただMicrosoft HoloLensを含め新デバイスの発表ではデバイスが変える『ビジョン』を発表することが多く、実際に発表されているビデオと現実が異なるということも大きくありました。これらの原因はデバイスの特性上実際にユーザーが着用しないとわからないビデオに落とし込めないという点と、単にコンテンツが不足しているという点があります。

後者に関しては非常に重大な問題で、MetaQuestでもコンテンツ不足を理由にユーザーが増えないという問題がありました。

iPhoneやAndoroidスマートフォンに比べどうしてもコンテンツが不足しがちになるからこそWWDCで発表され、同時に開発者向けのUnityなどの情報が出たと思っています。

また開発面に関してもAppleは独自路線でブランドの確立を行っていましたが、Unityでの開発を含め今回のWDDCでグラフィックス面でWindowsゲームをApple Silicon Macへ移植するためのツールGame Porting ToolkitがDirectX12に対応するなどによって開発面でも統合が行われているように感じます。

OpenXRに対応しているかどうかの情報は現時点では見つけられずKronosGroupのissueによると開発者がわも把握していないようです。

とここまで書いてきましたが、実際に24年になりデバイスが展開されるようになって良い意味で本記事の内容がひっくり返ることを期待しています。